7 月 11 日深夜,阿里巴巴投资的 AI 初创公司月之暗面(Moonshot AI)宣布开源其最新研发的万亿参数大模型 Kimi K2,引发了全球 AI 领域的广泛关注。该模型在多项基准测试中展现出卓越性能,尤其是在代码生成能力上超越了美国的主要竞争对手,且成本仅为对手的一小部分。

Kimi K2 模型的发布,是月之暗面在生成式 AI 竞赛中的重要一步。公司宣称,Kimi K2 在编码基准测试中表现超越了 Anthropic 的 Claude Opus 4 和 OpenAI 的 GPT-4.1,同时在价格上更具竞争力。通过 GitHub 和社交媒体发布的信息显示,Kimi K2 在生成计算机代码方面表现出色,这一领域被视为 AI 实现技术任务自动化或减少人力成本的关键。

创新技术铸就卓越性能

Kimi K2 作为 Kimi 最新的 MoE 基础模型,总参数达 1T,激活参数为 32B,其能力领先性在代码、Agent、数学推理任务上尤为显著。该模型采用了三大核心创新技术,为其卓越性能奠定了坚实基础。

- MuonClip 优化器:Kimi K2 抛弃了传统的 Adam 优化器,创新性地采用了 Muon 优化器,并结合 Muon 的 token 效率与 QK-Clip 的稳定性,支持 15.5 万亿 token 无损失 spike 预训练。在训练过程中,随着参数规模的急剧增长,注意力机制中的数值容易失控,导致训练过程崩溃,这是长期阻碍万亿参数模型发展的技术瓶颈。MuonClip 技术通过在每次优化器更新后,直接重新缩放查询(query)和键(key)投影的权重矩阵,从源头上精准地控制了注意力逻辑值的尺度,从而彻底杜绝了其 “爆炸” 的可能性,确保了大规模训练的连续性和有效性。

- 大规模 Agentic Tool Use 数据合成:团队构建了可大规模生成多轮工具使用场景的合成 pipeline,覆盖数百领域、数千工具。具体流程包括工具生成,涵盖 3000 多真实 MCP 工具及 20000 多合成工具,覆盖金融、机器人控制等广泛领域;Agentic 与任务生成,为工具集生成多样化 Agentic(系统提示 + 工具组合)和带评估标准的任务;轨迹生成,模拟用户交互、工具执行环境(含状态更新和随机结果),生成多轮工具使用轨迹,并结合真实执行沙箱(如编码任务),确保数据真实性。最终,Judge Agent 会依据任务 rubrics 对轨迹质量进行判断,只保留高质量样本用于训练。这一过程本质上是一种大规模拒绝采样机制,结合模拟规模与真实反馈,实现了大范围、高保真的训练数据构建。

- 通用强化学习框架:该框架结合可验证奖励(RLVR)和自我批判评估奖励,将对齐从静态扩展到开放域。在强化学习阶段,K2 主要经历了三大步骤。首先,构建可验证的奖励环境(Verifiable Rewards Gym),为不同任务设计 “可打分” 的训练场景,让模型的表现可以被客观评估,例如在编码场景中利用真实世界的数据构建任务,并通过自动化测试来验证模型的代码是否正确运行。其次,引入自我评估奖励机制(Self-Critique Rubric Reward),让模型将自己的多个输出结果进行两两比较,并根据一套明确的标准(如语言清晰度、对话是否连贯、是否啰嗦或拍马屁)给出奖励分,同时引入规则约束(如 “不要无脑称赞用户”)来避免生成套路化或迎合性回答,不仅增强了模型的自我反馈能力,也能将客观任务中的评估信号迁移到主观对话场景。最后,为了更高效、稳定地进行强化学习训练,K2 还对算法进行了多项改进,如采用预算控制机制限制每个样本的最大 token 数,避免生成啰嗦、重复或无意义的长文本;引入 PTX 辅助损失,使用高质量预训练样本时再加一个损失项,以防模型在 RL 阶段 “遗忘” 已有知识;采用温度衰减策略,训练初期用高温度鼓励模型大胆尝试、广泛探索,后期逐步降低温度,让模型输出更稳定、更收敛。

预训练:全新组合拳构建通用能力

在预训练阶段,Kimi K2 采用了 MoE 架构 + 稳定优化器 + 高效 token 利用的全新组合拳,以此构建通用语言和推理能力。

模型架构上,Kimi K2 一共包含 384 个专家,每层激活其中 8 个,通过这种高度稀疏的设计在保证性能的同时优化计算效率。在注意力机制上,K2 使用 MLA(Multi-head Latent Attention)结构代替传统的密集注意力(dense attention),有效减少了计算量和带宽压力,而且将每层的注意力头数量降至 64 个,与同类模型相比进一步降低了推理过程中的资源消耗,使模型能更好地处理长上下文。

数据方面,在高质量数据有限的情况下,K2 团队通过提升每 token 的有效学习信号(token 效用)来增强训练效率,避免重复训练导致的过拟合。为了让模型 “吃透” 有限的优质训练数据,K2 团队采取了 “重述法”。对于知识类文本,不是简单重复读,而是换着说法再讲一遍;对于数学类文本,把枯燥的教材式内容改写成更易理解的 “学习笔记” 风格,还加入了多语言版本的翻译文本。K2 的训练数据覆盖网页、代码、数学、知识四大板块,所有数据都经过严格的质量筛选。实验结果表明,用重写 10 次的数据训练 1 轮(28.94%),其准确率超过了用原始数据训练 10 轮(23.76%)的结果 。

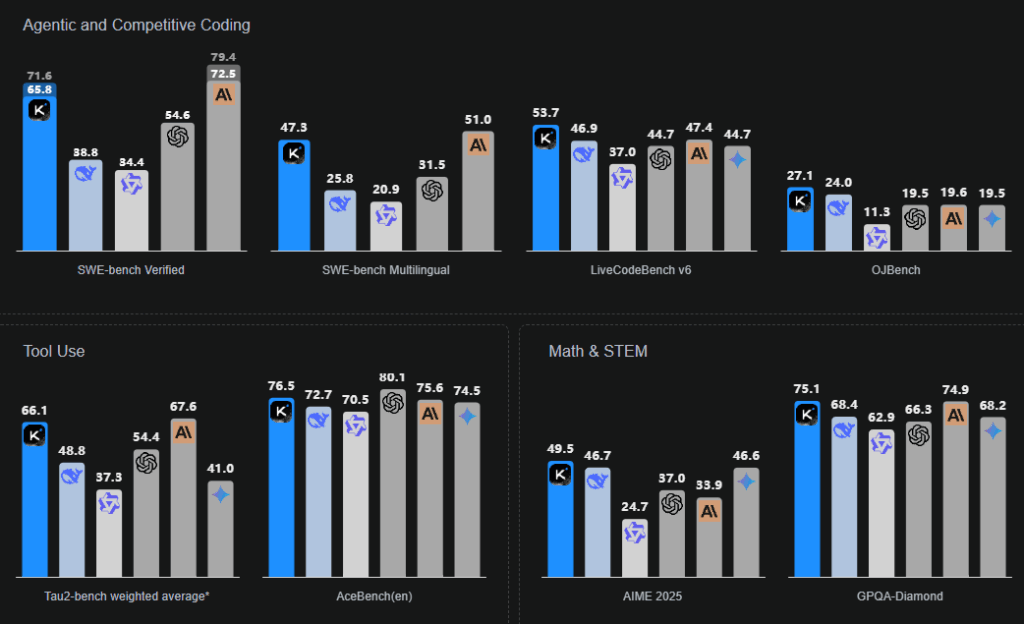

得益于以上技术,Kimi K2 在 SWE Bench Verified、Tau2、AceBench 等基准性能测试中,均取得开源模型中的最优成绩。

与需要订阅才能使用顶级模型的 ChatGPT 和 Claude 不同,Kimi K2 通过应用程序和浏览器界面向公众免费开放,成为中国公司迄今最易获取的高性能模型之一。月之暗面还为开发者提供了超低价格的使用方案:每百万输入令牌收费 0.15 美元,每百万输出令牌收费 2.50 美元,相比之下,Claude Opus 4 的收费分别为 15 美元和 75 美元,OpenAI 的 GPT-4.1 则为 2 美元和 8 美元。

Counterpoint Research 的首席 AI 分析师孙为表示,Kimi K2 “无疑具有全球竞争力”,其成本效益使其 “对预算敏感或大规模企业部署特别有吸引力”。月之暗面要求月活跃用户超过 1 亿或月收入达到 2000 万美元的商业用户在其界面上显示 “Kimi K2” 名称,除此之外,对模型的使用没有过多限制。

在 X(原 Twitter)和 GitHub 等平台上,早期用户的反馈大多积极。尽管模型偶尔会出现 “幻觉”(生成错误或虚构信息),这是行业普遍存在的问题,但早期使用者仍对其性能表示赞赏。AI 设计初创公司 MagicPath 的创始人 Pietro Schirano 称,Kimi K2 是自 Claude 3.5 Sonnet 以来,他首个放心部署使用的模型。

月之暗面是众多积极进军生成式 AI 领域的中国公司之一。由于 OpenAI 的 ChatGPT 在中国无法使用,中国本土的 AI 替代品获得了发展机会。随着字节跳动、腾讯和百度等公司的加入,竞争日益激烈。Kimi 的崛起反映出,随着全球 AI 竞争升温,投资者对中国 AI 挑战者的兴趣不断增长。

上个月,月之暗面发布的 Kimi Researcher 模型曾因在 “人类最后考试” 基准测试中的出色表现而成为焦点。该测试旨在评估高级推理能力,Kimi Researcher 的得分与谷歌 Gemini Deep Research 持平,超过了 OpenAI 的同类模型。甚至在埃隆・马斯克的 Grok 4 发布时,也提到了 Kimi Researcher 的成绩。

Kimi K2 的发布,标志着中国在 AI 技术领域的又一次重大突破,有望推动全球 AI 技术的进一步发展和应用。随着开源模型的不断优化和推广,AI 技术将更加普及,为各行各业带来更多创新机遇。